Un grupo internacional de astrónomos, en el que participa Miguel Ángel Pérez-Torres, del Instituto de Astrofísica de Andalucía (IAA-CSIC), en España, ha determinado que una de cada cinco supernovas que estallan en galaxias cercanas pasa desapercibida en los estudios ópticos, una tasa que aumenta hasta cuatro de cada cinco en el caso de las galaxias lejanas. El estudio, publicado en la revista The Astrophysical Journal, concuerda con la tasa de formación estelar que manejan los astrónomos y que había sido discutida en trabajos anteriores.

Profundidades del Universo develadas por la NASA

Los científicos de la Nasa anunciaron que con ayuda del telescopio espacial Hubble pudieron ver las galaxias que se formaron poco después del Big Bang, en el que surgió el Universo.

Físicos rusos podrían haber descubierto un nuevo bosón

La comunidad científica se muestra escéptica acerca del hallazgo

Especialistas rusos han descubierto huellas de la desintegración de un bosón ligero que no forma parte del Modelo Estándar de física de partículas. Han estimado su masa en ~38 megaelectronvoltios.

La Teoría M

Millones de agujeros negros observados por WISE

La misión Wide-field Infrared Survey Explorer (WISE) de la NASA ha dado con una gran cantidad de agujeros negros supermasivos y galaxias extremas conocidas como ‘hot DOGs’ (“Dust-Obscured Galaxies”), o galaxias calientes oscurecidas por el polvo.

Colisiones de agujeros negros producen ondulaciones del espacio-tiempo

¿Atrajeron los monstruosos agujeros negros las primeras galaxias, o nacieron dentro de aquellas galaxias? Es un antiguo misterio. Ahora, un nuevo análisis de las ondas gravitatorias de los agujeros negros en colisión podría revelar la respuesta, ayudando a los astrónomos a reconstruir una colisión y no sólo estudiar sus consecuencias.

Sabes como son en realidad los Agujeros Negros

Si hay algo que la mayoría de la gente sabe acerca de los agujeros negros, probablemente es que nada puede escapar de ellos, ni siquiera la luz.

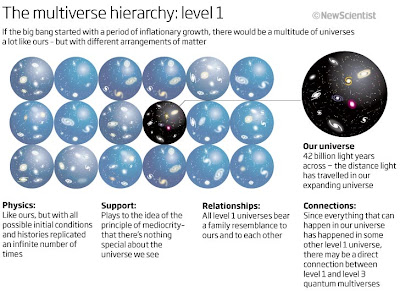

La guía del Multiverso

|

| Recreación, de Sam Chivers |

Ya sea que estemos buscando en el cosmos o sondeando en el reino subatómico, nuestras teorías con más éxito llevan a la ineludible conclusión de que nuestro universo es sólo una mota de polvo en un inmenso mar de universos.

Hasta hace poco, muchos físicos eran reacios a aceptar la idea del multiverso. Los recientes avances en la cosmología, la teoría de cuerdas y la mecánica cuántica, sin embargo, ha traído consigo un cambio de sentir al respecto. "El multiverso no es una especie de cosa opcional sobre la que puede elegir o no", comenta Raphael Bousso, un físico teórico de la Universidad de California, Berkeley. Nuestra propia historia cosmológica, nos dice que "está ahí y que tenemos que lidiar con ello".

En estos días, investigadores como Bousso están tratando el multiverso como algo real que investigar y probar, y ver lo que nos dice sobre nuestro universo. Uno de las principales motivaciones es la necesidad de explicar por qué las leyes físicas que subyacen en nuestro universo parecen tan ajustadas finamente para permitir que las galaxias, estrellas, planetas y la química compleja, la vida, y nosotros, podamos existir. En lugar de apelar a la suerte ciegs o un Dios, hay quienes sostienen que nuestra existencia establece unos parámetros de arranque fiable de universos como el nuestro, desde lo profundo del multiverso.

Sin embargo, hay un problema. Las diferentes teorías derivan en muy diferentes tipos de multiversos. La teoría estándar actual sobre el origen del universo, por ejemplo, predice una extensión infinita de otros universos, incluyendo un número infinito de duplicados de que usted está leyendo esta frase, y preguntándose si esas otras versiones realmente existen. Entre tanto, la teoría de cuerdas, que espera obtener de las partículas, las fuerzas y las constantes de los principios fundamentales de nuestro universo, en su lugar descubre un mar de 10500 universos, radicalmente diferentes al nuestro. Incluso la mecánica cuántica implica que nuestro universo es un solo copo dentro de una tormenta de nieve de universos paralelos (ver diagramas, "La jerarquía del multiverso").

|

| Jerarquía multiverso nivel 1. NewScientist.com |

Ahora nos enfrentamos a tratar de entender y relacionar estas ideas de uno con otro. En los últimos tiempos, hemos hecho enormes progresos para darle un sentido teórico a los conceptos del multiverso. Al mismo tiempo, varios grupos declaran haber hecho las observaciones astronómicas que apoyan esta idea. Parece que por fin estamos empezando a encontrar nuestro lugar dentro del universo de universos.

Podemos rastrear la idea de multiverso desde principios de 1980, cuando los físicos se dieron cuenta que el Big Bang creaba un problema igual de grande. Cuando los astrónomos medían su resplandor, esa conocida radiación del fondo cósmico de microondas (CMB), se encontraron con que era insondablemente uniforme, incluso en los extremos opuestos del universo visible. Se hallaban temperaturas coincidentes entre regiones muy distantes entre sí, dentro de 1/10.000 de grado, y como ahora sabemos eso es tan sorprendente como si encontráramos que sus habitantes, puesto el caso, hablaran el mismo idioma, señala Brian Greene, físico de la Universidad de Columbia en Nueva York.

El problema fue resuelto con brillantez por los cosmólogos Alan Guth, del Instituto Tecnológico de Massachusetts y Andrei Linde de la Stanford University, California, entre otros. Su idea era que en los primeros 10-35 segundos de existencia del universo, el espacio se expandió por un factor de alrededor de 1030. Este estiramiento, conocido como inflación, explica la uniformidad de la temperatura del CMB y resuelve otro enigma: por qué el espacio aparece plano, como la versión tridimensional de una tabla infinita. La inflación se ha convertido en una teoría de un éxito increíble, precisamente, porque predice las sutiles ondas ya medidas del CMB, que son el eco de las perturbaciones cuánticas que siembran las galaxias y las estrellas.

El intento de Guth y Linde por explicar nuestro universo también condujo directamente a un multiverso. Y esto es porque la inflación no se detiene en las regiones más remotas de las cuales viaja la luz hasta nosotros. Dependiendo de cómo se desarrolló la inflación, dice Guth, el universo podría ser 1010 ó 1020 veces, o incluso infinitamente más grande que el universo visible. La inflación implica una expansión más rápida que la velocidad de la luz, lo que significa que más allá del horizonte de nuestro universo observable, se encuentran otras partes del universo que están efectivamente separadas del nuestro. Ninguna influencia puede viajar entre estas regiones, básicamente, creando un número infinito de otros mundos.

|

| Jerarquía multiverso nivel 2. NewScientist.com |

¿Qué les parece? Max Tegmark, también un cosmólogo del MIT, señala que aunque la inflación predice una gran cantidad de universos, todos ellos disponen de las mismas partículas, fuerzas y leyes físicas que encontramos en nuestra parcela cósmica. Pero mientras que en nuestro universo partículas elementales forman estrellas y galaxias de una determinada manera, otro universo vecino contendrá una disposición diferente de estrellas y galaxias, y así otros de otros vecinos. No obstante, Tegmark ha demostrado que incluso si un universo como el nuestro estuviese completamente lleno de partículas elementales, sólo pueden estar dispuestas en un número finito de formas. Es un número enorme, 2 elevado a la potencia de 10118, pero puesto que no hay señales de que el espacio sea finito, hay espacio para que cualquier disposición pueda repetirse.

Esto significa que si usted viaja lo suficiente, tarde o temprano se encontrará con un universo que contiene una copia idéntica de usted. Tegmark ha calculado que su copia más cercana vive a 10 elevado a la potencia de 1029 metros de distancia. Y un universo gemelo al nuestro podría encuentrarse a 10 elevado a la potencia de 10118 metros de aquí (arxiv.org/abs/0905.1283v1). En la medida que un universo infinito alberga un infinito número de variaciones, en algún lugar tú acabas de ganar los 100 metros olímpicos, así que, ¡Felicitaciones!

Tan abundantes como son estos universos, no significa que haya nada de exótico sobre ellos. Las clases de universos de Tegmark implican una inflación simple, o una expansión infinita del espacio como en el primer nivel de una jerarquía de cuatro niveles, esto cada vez es más extraño.

Tomemos el segundo tipo de multiverso. Poco después de que la inflación fuese descubierta, Linde dijo que podría ser un proceso continuo y eterno. Cuando la enorme energía del espacio vacío crea un universo bebé de la inflación, el espacio a su alrededor, todavía crepita con la energía, y sigue creciendo aún más rápido. De ese espacio podrína brotar más universos que se autoinflacionan, y así sucesivamente. "Prácticamente todos los modelos de inflación que se han discutido predicen la inflación eterna", comenta Alexander Vilenkin en la Universidad Tufts de Boston, que fue pionero de la idea en la década de 1980.

La enorme variedad de inflación eterna incluyen un número infinito de universos de nivel 1, aunque muchas otras variedades también. Cada universo se convierte de forma diferente, por lo que las características que se pensaban universales, como la masa de las partículas elementales y la fortaleza de las fuerzas fundamentales, también son diferentes. Los universos burbuja de la inflación eterna incluyen todas las permutaciones que permiten las leyes de la física.

Estos universos son parte del segundo nivel de jerarquía del multiverso de Tegmark. Entre ellos, algunos de la serie de 10500 universos implícitos en la teoría de cuerdas, el principal contendiente para una "teoría del todo" que explique todas las partículas y las fuerzas de la naturaleza.

|

| Jerarquía multiverso nivel 3. NewScientist.com |

Modelo estándar actual de la física de partículas incluye una veintena de parámetros, cuyos valores físicos se pueden medir, pero no se pueden explicar, como la masa de un electrón. Los teóricos de las cuerdas esperaban que su teoría explicaría por qué esos parámetros tienen esos valores, y de esta manera, saber por qué nuestro universo es como es.

Fuimos contrariados seriamente. En lugar de producir un perfecto copo de nieve (las partículas, las fuerzas e interacciones que sustentan nuestro universo), la teoría de cuerdas desató una avalancha de universos, una desmoralizadora expansión que Leonard Susskind, físico teórico en la Universidad de Stanford, denominó el paisaje de la teoría de cuerdas.

Lo que diferencia a estos universos es la naturaleza de su espacio-tiempo. En la teoría de cuerdas, las partículas de la naturaleza y las fuerzas provienen de las vibraciones de pequeñas cuerdas en 10 dimensiones. La razón de que sólamente experimentemos cuatro dimensiones es porque el resto están "compactadas" o anudadas dentro intrincadas estructuras, demasiado pequeñas para nuestro nivel de experiencia. El papel que juega la física en cualquier universo dado depende de cuántas dimensiones son trituradas y de su estructura. Los investigadores han identificado un gran número de formas posibles que interactúan con los campos de la teoría de cuerdas que definen un gran número de universos, la mayoría con unas leyes físicas desconocidas, y fuerzas y partículas radicalmente distintas.

La inflación eterna proporciona un mecanismo convincente para llenar todos los puntos en este paisaje de la teoría de cuerdas con un número infinito de universos reales. "Al principio, los teóricos de cuerdas no le gustaba la idea del multiverso y querían tener una única solución, en cambio se encontraron con 10500", dice Linde. "Ahora tenemos que aprender a convivir con un universo que nos ofrece una enorme multitud de opciones."

Averiguar por qué nuestro universo es como es, cuando hay un gran número de alternativas, sigue siendo uno de los mayores retos de la cosmología. Nuestro universo parece inexplicablemente un ajuste fino que produce las condiciones necesarias para la vida. Si la gravedad fuera un poco más fuerte, el Big Bang habría sido un petardo. Un poco más débil y no se podría haber formado las galaxias y las estrellas. Si la carga electrónica difiere en unos pocos puntos porcentuales, las estrellas no podrían haber creado los elementos pesados que forman los planetas como la Tierra. Si la fuerza nuclear fuerte variara a la mitad de su porcentaje, el carbono no existiría, y por ende tampoco la vida tal y como la conocemos. Encabezando la lista del ajuste fino está nuestra pequeña constante cosmológica del universo, una pequeña dosis de energía oscura que es la fuente de la expansión acelerada del universo.

El descubrimiento en la década de 1990 de que la expansión del universo se está acelerando, sorprendió a la mayoría de los cosmólogos. La teoría cuántica predice un nivel de energía oscura de alrededor de 10120 veces más grande que lo que se ha encontrado. A partir de la explosión del universo, la mayoría de los investigadores habían asumido que una cierta simetría no descubierta cancelaría esa enorme cantidad, dejando la constante cosmológica a cero. Nadie predijo que no sería cero, excepto una persona.

Una década antes, Steven Weinberg, físico ganador del premio Nobel, de la Universidad de Texas, en Austin, había predicho una pequeña constante cosmológica positiva. Y esa idea le vino por aplicar el razonamiento antrópico al multiverso, un enfoque que sigue siendo muy discutido. Weinberg razonaba que para que un universo generara las galaxias, y por lo tanto estrellas y planetas, la cantidad de energía oscura debía de caer dentro de cierto rango para que nosotros desde aquí podamos medirlo. Esto equivale a centrarse en un subconjunto de universos dentro del multiverso que tienen esas propiedades. Este enfoque probabilístico permitió a Weinberg predecir el valor de la constante cosmológica con una notable precisión.

"El descubrimiento de la constante cosmológica fue uno de los descubrimientos más inesperados del siglo pasado, y se pudo predecir debido al multiverso", señala Vilenkin. "Así que es una evidencia indirecta de que vivimos en un multiverso".

Desde entonces, otros investigadores han usado el razonamiento antrópico para limitar la cantidad de energía oscura, la proporción de materia oscura con la materia ordinaria, y la masa de las partículas elementales como los neutrinos y los quarks. Utilizando el razonamiento antrópico para filtrar nuestro tipo de universo desde el multiverso, al parecer, eso podría explicar ese misterioso ajuste fino. Podría, y de hecho, es la única manera. "Si las leyes y constantes físicas son diferentes en otros lugares", apunta Martin Rees, astrónomo de la Universidad de Cambridge, "es inevitable."

Lamentablemente hay un problema con el uso de este enfoque, para dilucidar la ubicación de nuestro universo en el multiverso: las reglas habituales de probabilidad no son aplicables, por lo que es imposible estimar la probabilidad de universos como el nuestro. "Si tenemos un número infinito de lugares donde ganar a la lotería, y un número infinito de donde no lo hacerlo ¿cuál sería la base para decir que ganar a la lotería es poco probable?" aduce Bousso. "Es como tirar de la alfombra bajo nuestro, para probar si una teoría es correcta o incorrecta."

Este "problema de medida" podría haber sido resuelto por Bousso y su estudiante I-Sheng Yang, ahora en la Universidad de Columbia. Se deshicieron de los molestos infinitos mediante una derivación de probabilidades de los parámetros de un universo local, quitando todo con lo que un observador nunca podrá interactuar. Estas probabilidades encontraron coincidencias con las de un enfoque alternativo promovido por Vilenkin y Jaume Garriga, en la Universidad de Barcelona, España, colocando las predicciones del multiverso en lo que, por primera vez, parecía tener una base sólida (New Scientist, 6 March 2010, p 28)

Mientras que los teóricos han hecho grandes avances en la comprensión de la cosmología de los multiversos, todavía quedan otros dos niveles de la jerarquía de Tegmark. El nivel 3 tiene sus orígenes en la teoría cuántica. Los físicos aceptan que la mecánica cuántica funciona brillantemente. Se puede utilizar, por ejemplo, para calcular el valor del momento magnético del electrón, y ser coincidente con las mediciones en una parte de mil millones. Sin embargo, todavía no han podido ponerse de acuerdo sobre lo que significa. En el reino cuántico, las partículas no existen como entidades separadas que se puedan precisar, sino como "ondas de probabilidad". La evolución de dichas ondas son lo que permite a los físicos predecir cómo los electrones cubren un átomo, cómo interactúan los quarks y los gluones, e incluso, cómo los objetos tan grandes, como los buckyballs pueden interferir como las ondas de luz (New Scientist, 8 May 2010, p 36)

La cuestión fundamental es qué pasa con las ondas de probabilidad de un objeto (su función de onda) cuando alguien lo mide. Niels Bohr, uno de los fundadores de la mecánica cuántica, declaró que la observación de una función de onda originaba su colapso y en su lugar aparece una partícula en un momento y lugar determinado. Eso explica por qué vemos tan sólo un resultado, entre las infinitas posibilidades que caracterizan la función de onda.

Sin embargo, la interpretación de Bohr ha sido muy criticada, porque sugiere que nada vuelve realidad hasta que alguien lo observa. En la década de 1950, estos argumentos llevaron a Hugh Everett, entonces estudiante graduado en la Universidad de Princeton, a explorar lo que ocurriría si desechara el argumento de Bohr. Cuando Everett representó la función de onda rodando a sus anchas, como las matemáticas de la teoría cuántica dijeron que lo hacía, llegó a una conclusión aún más sorprendente y controvertida. Conocida como la interpretación de los universos paralelos, se requiería la existencia de un vasto enjambre de universos paralelos al nuestro, en el que todas las posibilidades que pueden materializarse.

¿Son reales los mundos paralelos? Tan real como los dinosaurios, dice David Deutsch, un físico cuántico de la Universidad de Oxford. "Sólo hemos visto los fósiles y los dinosaurios son la única explicación racional para ellos", añade. "El que haya muchos mundos es la única explicación racional para los fenómenos cuánticos que observamos. Creo que esto es tan bueno como lo de los dinosaurios."

Los mundos paralelos de la teoría cuántica y los universos múltiples creados por la inflación eterna, no podría parecer más diferentes. Sin embargo, los teóricos han comenzado a explorar la idea de que ambos paisajes sean el mismo (New Scientist, 4 June, p 8). Bousso y Susskind, argumentan que ellos producen la misma colección de universos paralelos. "Pensamos desde hace mucho tiempo que la idea del multiverso y la de universos paralelos son descripciones redundantes de la misma cosa", señala Susskind. A principios de este año, él y Bousso, desarrollaron una forma coherente de aplicación de las reglas cuánticas para el multiverso. El multiverso inflacionario, concluyen, es simplemente una colección de todos los universos burbuja que permite la mecánica cuántica. "La realidad posibilística de la mecánica cuántica convierte esas realidades genuinas en el multiverso," agregó Susskind.

Tegmark también compara las infinitas variantes de nuestro universo en el multiverso de nivel 1, a una infinidad de mundos cuánticos. "La única diferencia entre el nivel 1 y el nivel 3", dice, "es dónde reside su doble".

Los multiversos mencionados hasta ahora, disminuyen el estatus de nuestro universo a la categoría de una piedra en un vasto paisaje, pero al menos permitirá que sea real. El filósofo Nick Bostrom, de la Universidad de Oxford, sube la apuesta, con el argumento de que nuestra experiencia del universo es tan sólo una simulación ejecutada en la supercomputadora de una civilización avanzada.

|

| Jerarquía multiverso nivel 4. NewScientist.com |

Su argumento es simple. Unas civilizaciones que en el pasado desarrollaron una potencia de cálculo prácticamente ilimitado. Alguna de ellas recorrieron "simulaciones de antepasados", unas reconstrucciones de sus antepasados o de otros seres. Al igual que millones de nosotros cuando jugamos a los videojuegos, como "Los Sims", una civilización de trans-humanos probablemente ejecutando simulaciones múltiples, así que ve posible que estemos en alguna de ellas. Bostrom duda de que encontremos pruebas de que lo que hacemos o lo que vivamos sea en una simulación. Argumenta que una civilización avanzada, lo suficientemente inteligente como para crear una simulación, en primer lugar evitaría que la gente del interior se pudiese dar cuenta de tal problema, o borraría las evidencias. Aunque Tegmark categoriza ésta y varias incursiones más especulativas como multiversos de nivel 4.

Puede que no seamos capaces de probar o refutar una simulación, pero ¿qué pasa con otros los tipos de multiversos? Los teóricos apuntan a varias formas en que otros universos podrían dejarnos señales que podamos observar. Por ejemplo, los universos burbuja de una inflación eterna pueden colisionar. El resultado podría ser la aniquilación. "Si estás en una burbuja y la pared se acelera hacia usted, suele ser una mala noticia", dice Matthew Kleban, físico teórico de la Universidad de Nueva York. Sin embargo, en algunos casos, las burbujas rebotan, dejando una mancha delatadora en el CMB. Kleban y sus colegas han calculado esos detalles, una mancha simétrica dentro de un rango dado de tamaños, se distinguiría de su entorno, ya que tendría una temperatura y una polarización diferente (arxiv.org/abs/1109.3473).

Pues, algo similar se ha visto en el CMB, pero Kleban admite que la evidencia de una colisión es todavía débil. Sin embargo, dice, una colisión podría ser confirmada por los datos del satélite Planck, que está estudiando el CMB, o tal vez en futuras misiones. Tal descubrimiento podría provocar una nueva revolución copernicana. "Se nos diría que estamos dentro de una burbuja, que está integrada junto con un gran número de otras burbujas, y con diferentes leyes de la física", declara. "Eso sería un descubrimiento sensacional."

La mecánica cuántica predice que los universos emergentes comienzan entrelazados unos con otros. Que ese temprano entrelazamiento puede dejar signos de larga duración. "En el momento en que haya un mecanismo físico que muestre cómo nace un universo, acabas con una serie de predicciones de cómo ese universo podría terminarse", señala Laura Mersini-Houghton, cosmóloga de la Universidad de Carolina del Norte, en Chapel Hill. Ella y sus colegas utilizaron este enfoque para generar cuatro predicciones que, según ella afirma, todas han sido confirmadas.

Uno de ellos fue la existencia de un vacío enorme en nuestro universo. Los datos del satélite WMAP de la NASA y el Sloan Digital Sky Survey muestran que algo similar se esconde en la constelación de Eridanus (New Scientist, 24 November 2007, p 34). También predijo que la intensidad global de la CMB debería ser aproximadamente del 20 por ciento menos de lo previsto por la inflación y, sorprendentemente, que todo nuestro universo fluye en una dirección particular. "Eso era tan escandaloso que nadie lo creyó", aduce Mersini-Houghton, "pero ha sido confirmado" (New Scientist, 24 January 2009, p 50)

La predicción más controvertida de su grupo consiste en la física de partículas. La mayoría de los físicos esperan que las colisiones en el Gran Colisionador de Hadrones en Suiza, cerca de Ginebra, revelan los primeros signos de una nueva simetría de la naturaleza conocida como supersimetría. Considerada como un ingrediente esencial de la teoría de cuerdas, la supersimetría requiere que cada partícula del modelo estándar tenga un pareja pesada en espera de ser descubierta. La mayoría de los investigadores creen que las altas energías del LHC son suficientes para destapar estas bestias.

Sin embargo, Mersini-Houghton ha predicho que se necesita 10.000 veces más energía. Hasta el momento no han aparecido signos de la supersimetría (New Scientist, 19 March, p 10). Aunque algunos investigadores están intrigados, la mayoría están tomando la actitud de esperar y ver esta ambiciosa aplicación de la mecánica cuántica en el multiverso.

Los teóricos han comenzado a explorar otras predicciones comprobables, derivadas de los diversos tipos de multiversos. Por ejemplo, la de si el espacio es plano o ligeramente curvado y si están en juego otras partículas y fuerzas que las predichas por el modelo estándar o la supersimetría (New Scientist, 19 July 2008, p 36).

A tres décadas desde que el concepto nació, muchos investigadores están de acuerdo en que al menos algunos tipos de multiverso mantienen firmes sus fundamentos teóricos, el rendimiento de las predicciones de astrónomos y los físicos de partículas se pueden probar, y eso ayuda a explicar por qué nuestro universo es como es. Sin embargo, dice Bousso, los multiversos existen en la frontera de la ciencia. "Nunca se sabe nada con seguridad cuando se trabaja con los límites del conocimiento", señala. "Pero si yo no creyera que fuese la mejor opción, no perdería mi tiempo con ello". Susskind está de acuerdo, y añade: "No estamos ni siquiera cerca cuestiones finales. Seguro que saldrán sorpresas."

Referencia:

NewScientist.com, 28 de noviembre 2011 por Robert Adler [escritor independiente y autor de of Science Firsts (John Wiley & Sons, 2002) and Medical Firsts (John Wiley & Sons, 2004)]

Partículas exóticas forman una onda gigante de materia

Los físicos han conseguido atrapar y enfriar las partículas exóticas llamadas excitones, con tal eficacia que se condensan y cohesionan para formar una onda gigante de materia.

Esta hazaña permitirá a los científicos estudiar mejor las propiedades físicas de los excitones, los cuales existen sólo fugazmente, aunque ofrecen tan prometedoras como diversas aplicaciones, entre ellas la recolección eficiente de la energía solar y la computación ultrarrápida.

"Esta realización de un excitón condensado en una trampa nos da la oportunidad de estudiar este interesante estado. Las trampas permiten el control de la condensación, proporcionando una nueva forma de estudiar las propiedades fundamentales de la luz y la materia", explicaba Leonid Butov, profesor de física en la Universidad de California en San Diego.

Los excitones son partículas compuestas de un electrón y un "hueco" dejado por un electrón perdido, en un semiconductor. Creado por la luz, estos pares acoplados existen en la naturaleza. La formación y la dinámica de los excitones desempeñan un papel fundamental en la fotosíntesis, por ejemplo.

Igual que otro forma de materia, los excitones tienen una naturaleza dual de partícula y onda, desde el punto de vista cuántico. Las ondas, en general, no están sincronizadas, pero cuando las partículas se enfrían lo suficiente hasta condensarse, sus ondas se empiezan a sincronizar y combinar formando una onda gigante de materia, un estado que otros han observado en los átomos.

Los científicos pueden crear excitones fácilmente por el brillo de la luz en un semiconductor, pero a fin de que los excitones se condensen deben ser enfriados antes de que puedan recombinarse.

La clave del éxito del equipo fue la de separar los electrones lo bastante lejos de sus huecos para que los excitones lograsen durar lo suficiente, y así los científicos podían enfriarlos en un condensado. Esto se obtuvo mediante la creación de unas estructuras llamadas "huecos cuánticos acoplados" que separan los electrones de los huecos en diferentes capas de aleaciones hechas de arsénico de galio y aluminio.

Luego dispusieron una trampa electrostática que consistía en un electrodo formado de diamante, y lo enfriaban en un material semiconductor especial, hecho de una dilución óptica refrigerante, enfriada a 50 mili-Kelvin, tan sólo una fracción de un grado sobre el cero absoluto.

El láser enfocado sobre la superficie del material creaba excitones, que comenzaban a acumularse en el fondo de la trampa ya enfriada. Por debajo de 1 kelvin, toda la nube de excitones se cohesionaba para formar una sola onda de materia, la huella de un estado conocido como condensado de Bose-Einstein.

Otros científicos han visto a los átomos enteros hacer esto, cuando son confinados en una trampa y enfriados, pero esta es la primera vez que se ha comprobado que partículas subatómicas formen ondas coherentes de materia dentro de una trampa.

La variación del tamaño y la profundidad de la trampa alterará el estado coherente del excitón, lo que proporciona a este equipo, y a otros, la oportunidad de estudiar las propiedades de la luz y la materia en una forma completamente nueva.

Referencia:

"Esta realización de un excitón condensado en una trampa nos da la oportunidad de estudiar este interesante estado. Las trampas permiten el control de la condensación, proporcionando una nueva forma de estudiar las propiedades fundamentales de la luz y la materia", explicaba Leonid Butov, profesor de física en la Universidad de California en San Diego.

Los excitones son partículas compuestas de un electrón y un "hueco" dejado por un electrón perdido, en un semiconductor. Creado por la luz, estos pares acoplados existen en la naturaleza. La formación y la dinámica de los excitones desempeñan un papel fundamental en la fotosíntesis, por ejemplo.

Igual que otro forma de materia, los excitones tienen una naturaleza dual de partícula y onda, desde el punto de vista cuántico. Las ondas, en general, no están sincronizadas, pero cuando las partículas se enfrían lo suficiente hasta condensarse, sus ondas se empiezan a sincronizar y combinar formando una onda gigante de materia, un estado que otros han observado en los átomos.

Los científicos pueden crear excitones fácilmente por el brillo de la luz en un semiconductor, pero a fin de que los excitones se condensen deben ser enfriados antes de que puedan recombinarse.

La clave del éxito del equipo fue la de separar los electrones lo bastante lejos de sus huecos para que los excitones lograsen durar lo suficiente, y así los científicos podían enfriarlos en un condensado. Esto se obtuvo mediante la creación de unas estructuras llamadas "huecos cuánticos acoplados" que separan los electrones de los huecos en diferentes capas de aleaciones hechas de arsénico de galio y aluminio.

Luego dispusieron una trampa electrostática que consistía en un electrodo formado de diamante, y lo enfriaban en un material semiconductor especial, hecho de una dilución óptica refrigerante, enfriada a 50 mili-Kelvin, tan sólo una fracción de un grado sobre el cero absoluto.

El láser enfocado sobre la superficie del material creaba excitones, que comenzaban a acumularse en el fondo de la trampa ya enfriada. Por debajo de 1 kelvin, toda la nube de excitones se cohesionaba para formar una sola onda de materia, la huella de un estado conocido como condensado de Bose-Einstein.

Otros científicos han visto a los átomos enteros hacer esto, cuando son confinados en una trampa y enfriados, pero esta es la primera vez que se ha comprobado que partículas subatómicas formen ondas coherentes de materia dentro de una trampa.

La variación del tamaño y la profundidad de la trampa alterará el estado coherente del excitón, lo que proporciona a este equipo, y a otros, la oportunidad de estudiar las propiedades de la luz y la materia en una forma completamente nueva.

Referencia:

Kurzweilai.net, 28 mayo 2012

A. A. High, J. R. Leonard, M. Remeika, L. V. Butov, M. Hanson, A. C. Gossard, Condensation of Excitons in a Trap, Nano Letters, 2012, DOI: 10.1021/nl300983n .

A. A. High, J. R. Leonard, M. Remeika, L. V. Butov, M. Hanson, A. C. Gossard, Condensation of Excitons in a Trap, Nano Letters, 2012, DOI: 10.1021/nl300983n .

Simulación tridimensional del nacimiento del universo

Los científicos del Centro de Astrofísica Harvard-Smithsonian, en colaboración con sus colegas del Instituto Heidelberg de Estudios Teóricos (HITS, por sus siglas en inglés), han creado una detallada simulación tridimensional del nacimiento y la evolución de nuestro universo.

| youtube.com |

Los científicos afirman que su modelo tiene una extrema precisión, ya que en su creación estuvieron involucrados todos los recientes avances de la humanidad en las teorías de la gravitación, dinámica de gases astrofísicos, materia oscura, etc.

"Hemos recreado toda la variedad de galaxias que vemos en el universo local”, dijo Mark Vogelsberger, del Centro de Astrofísica.

Para desarrollar un simulacro tan complicado los especialistas recurrieron a una supercomputadora con 1.024 núcleos de procesadores y tuvieron que crear un nuevo software, llamado Arepo. Según Volker Springel, especialista del HITS, Arepo genera una simulación del universo, tomando únicamente como inicio el resplandor observado del Big Bang, haciéndolo evolucionar durante 14.000 millones de años.

Puesto que durante los primeros 4.000 millones de años tras el Big Bang, nuestro universo fue un simple cúmulo de gases, este “aburrido” detalle se omite de la simulación, que empieza en ese punto.

"Hemos recreado toda la variedad de galaxias que vemos en el universo local”, dijo Mark Vogelsberger, del Centro de Astrofísica.

Para desarrollar un simulacro tan complicado los especialistas recurrieron a una supercomputadora con 1.024 núcleos de procesadores y tuvieron que crear un nuevo software, llamado Arepo. Según Volker Springel, especialista del HITS, Arepo genera una simulación del universo, tomando únicamente como inicio el resplandor observado del Big Bang, haciéndolo evolucionar durante 14.000 millones de años.

Puesto que durante los primeros 4.000 millones de años tras el Big Bang, nuestro universo fue un simple cúmulo de gases, este “aburrido” detalle se omite de la simulación, que empieza en ese punto.

Construyendo un cristal de espacio-tiempo

Nadie ha visto nunca un cristal de espacio-tiempo y mucho menos lo ha hecho; pero ahora los físicos piensan que saben cómo hacerlo.

Hace un par de meses, nos fijamos en la noción de cristales de tiempo, una idea propuesta por el ganador del Nóbel, el físico Frank Wilczek, y su amigo Al Shapere.

Ellos examinaron las propiedades fundamentales de los cristales ordinarios espaciales y se cuestionaron por qué objetos similares no podrían existir a la vez en una dimensión del tiempo.

Una de las propiedades básicas de los cristales espaciales es que forman un sistema que cae a su estado de energía lo más bajo posible. No son el resultado de una adición de energía a un sistema, sino de quitársela.

Otra característica básica es que cuando estos objetos llegan a su configuración de energía más baja, se rompe su simetría. En lugar de ser la misma en todas las direcciones, tal como dictan las leyes de la física, estos objetos respetan la misma simetría en tan sólo unas cuantas direcciones. Esta ruptura de la simetría y de la estructura periódica produce lo que define a los cristales.

Wilczek y Shapere argumentan de manera persuasiva que no hay ninguna razón por la que similares estructuras periódicas no puedan existir en el tiempo. Y, según dijeron, se dispusieron a dar a los físicos una nueva forma de estudiar el proceso de ruptura de la simetría y de las leyes de la física que hay detrás.

Sólo había un problema. Que no habían calculado la forma de construir un cristal de tiempo.

Con los cambios de hoy junto al trabajo de Tongcang Li de la Universidad de California, en Berkeley, y algunos compañeros, dicen haber trabajado en cómo hacerlo, que saben cómo crear un objeto en su estado de menor energía que muestre la estructura periódica, tanto espacial como temporal, un cristal de espacio-tiempo.

La idea es muy simple. El cristal de espacio-tiempo se compone de una nube de iones de berilio atrapados en un campo electromagnético circular. Los iones, de forma natural, se repelen entre sí y forman espontáneamente un círculo. Esto es un tipo de cristal espacial iónico, algo que los físicos han hecho durante años.

Sin embargo, si Wilczek y Shapere están en lo cierto, este anillo de iones debería rotar, aun cuando se haya enfriado hasta casi el cero absoluto. Un anillo giratorio así es periódico, tanto en el espacio como en el tiempo, convirtiéndose así en un cristal de espacio-tiempo.

La idea de un anillo en permanente rotación podría tener paralelismos incómodos con un dispositivo de movimiento perpetuo. Sin embargo, un cristal de espacio-tiempo no viola las leyes de la física. Porque existe en un estado de mínima energía y por tanto no puede funcionar, no se puede extraer la energía de este sistema pese a estar en movimiento.

Esto es más que una mera curiosidad. Una razón por la cual los cristales de espacio-tiempo son interesantes es que su periodicidad en el tiempo los vuelve relojes naturales. Así que debe haber mucha gente muy interesada en hacer uno.

Y eso vendrá más pronto que tarde. El cristal de espacio-tiempo de la Tongcang y compañía, hará posible hacer ahora un estado de trampas de iones de arte. Ellos no quieren que nadie les robe la idea, así que es muy probable que Tongcang y compañía estén construyendo uno ahora. Quizás tengan ya un cristal de espacio-tiempo en su laboratorio.

Si este es el caso, seguramente leeremos más detalles sobre el primer cristal de espacio-tiempo algunos de estos días o semanas que vienen.

Referencia: Artículo publicado

Hace un par de meses, nos fijamos en la noción de cristales de tiempo, una idea propuesta por el ganador del Nóbel, el físico Frank Wilczek, y su amigo Al Shapere.

Ellos examinaron las propiedades fundamentales de los cristales ordinarios espaciales y se cuestionaron por qué objetos similares no podrían existir a la vez en una dimensión del tiempo.

Una de las propiedades básicas de los cristales espaciales es que forman un sistema que cae a su estado de energía lo más bajo posible. No son el resultado de una adición de energía a un sistema, sino de quitársela.

Otra característica básica es que cuando estos objetos llegan a su configuración de energía más baja, se rompe su simetría. En lugar de ser la misma en todas las direcciones, tal como dictan las leyes de la física, estos objetos respetan la misma simetría en tan sólo unas cuantas direcciones. Esta ruptura de la simetría y de la estructura periódica produce lo que define a los cristales.

Wilczek y Shapere argumentan de manera persuasiva que no hay ninguna razón por la que similares estructuras periódicas no puedan existir en el tiempo. Y, según dijeron, se dispusieron a dar a los físicos una nueva forma de estudiar el proceso de ruptura de la simetría y de las leyes de la física que hay detrás.

Sólo había un problema. Que no habían calculado la forma de construir un cristal de tiempo.

Con los cambios de hoy junto al trabajo de Tongcang Li de la Universidad de California, en Berkeley, y algunos compañeros, dicen haber trabajado en cómo hacerlo, que saben cómo crear un objeto en su estado de menor energía que muestre la estructura periódica, tanto espacial como temporal, un cristal de espacio-tiempo.

La idea es muy simple. El cristal de espacio-tiempo se compone de una nube de iones de berilio atrapados en un campo electromagnético circular. Los iones, de forma natural, se repelen entre sí y forman espontáneamente un círculo. Esto es un tipo de cristal espacial iónico, algo que los físicos han hecho durante años.

Sin embargo, si Wilczek y Shapere están en lo cierto, este anillo de iones debería rotar, aun cuando se haya enfriado hasta casi el cero absoluto. Un anillo giratorio así es periódico, tanto en el espacio como en el tiempo, convirtiéndose así en un cristal de espacio-tiempo.

La idea de un anillo en permanente rotación podría tener paralelismos incómodos con un dispositivo de movimiento perpetuo. Sin embargo, un cristal de espacio-tiempo no viola las leyes de la física. Porque existe en un estado de mínima energía y por tanto no puede funcionar, no se puede extraer la energía de este sistema pese a estar en movimiento.

Esto es más que una mera curiosidad. Una razón por la cual los cristales de espacio-tiempo son interesantes es que su periodicidad en el tiempo los vuelve relojes naturales. Así que debe haber mucha gente muy interesada en hacer uno.

Y eso vendrá más pronto que tarde. El cristal de espacio-tiempo de la Tongcang y compañía, hará posible hacer ahora un estado de trampas de iones de arte. Ellos no quieren que nadie les robe la idea, así que es muy probable que Tongcang y compañía estén construyendo uno ahora. Quizás tengan ya un cristal de espacio-tiempo en su laboratorio.

Si este es el caso, seguramente leeremos más detalles sobre el primer cristal de espacio-tiempo algunos de estos días o semanas que vienen.

Referencia: Artículo publicado

Nuestras elecciones futuras afectan a nuestro pasado

Lo que hagas hoy podría afectar a lo que pasó ayer, esta es la increíble conclusión de un experimento mental de física cuántica, descrita en un artículo publicado por Yakir Aharonov, y sus colegas, de la Universidad de Tel Aviv, en Israel.

Suena imposible, de hecho puede estar violando uno de los principios más preciados de la ciencia, la causalidad, pero los investigadores dicen que las reglas del mundo cuántico conspiran para preservar la causalidad "ocultando" la influencia de las futuras elecciones hasta que esas decisiones hayan sido efectivamente realizadas.

Ocupando el corazón de esta idea está el fenómeno cuántico de "no localidad", en el que dos o más partículas existen en estados interrelacionados o "entrelazados", algo que queda indeterminado hasta que se efectúa la medición de uno de ellos. Una vez que la medición se lleva a cabo, el estado de la otra partícula instantáneamente también queda fijado, sin importar lo lejos que pueda estar. Albert Einstein, lo denominó "acción a distancia" en 1935, cuando argumentaba que la teoría cuántica debe estar incompleta. Los experimentos modernos han confirmado que esta 'acción instantánea', es de hecho, una realidad, y ahora resulta clave para llevar las tecnologías cuánticas a la práctica, como la computación cuántica y la criptografía.

Aharonov y sus colaboradores, describen el experimento para un gran grupo de las partículas entrelazadas. Y afirman que, bajo ciertas condiciones, la elección del experimentador que mide los estados de las partículas, se puede demostrar que afectan a los estados que tenían las partículas en un tiempo anterior, cuando se hizo una holgada medición. En efecto, la anterior medición "débil" se anticipa a la elección hecha en la posterior medición "fuerte".

4D en lugar de 3D

Este trabajo se basa en una forma de pensar acerca del entrelazamiento, llamada "two-state vector formalism" [formalismo vectorial de dos estados] (TSVF), propuesto por Aharonov hace tres décadas. La TSVF considera las correlaciones entre las partículas en un espacio-tiempo 4D, en lugar de un espacio 3D. "En tres dimensiones, parece que existe alguna influencia milagrosa entre las dos partículas distantes", dice el colega de Aharonov, Avshalom Elitzur, del Instituto de Ciencia Weizmann en Rehovot, Israel. "Tomado el espacio-tiempo como un todo, resulta una interacción continua que se extiende entre los eventos pasados y futuros."

Aharonov y su equipo, han descubierto ahora una implicación notable de la TSVF que incide sobre la cuestión de en qué estado está una partícula entre dos mediciones, una versión cuántica del famoso acertijo de Einstein sobre cómo podemos estar seguros de que la Luna está ahí sin mirarla. ¿Cómo podemos averiguar algo acerca de las partículas sin medirlas? La TSVF muestra que es posible llegar a esa información intermedia, haciendo mediciones suficientemente "débiles" de un montón de partículas entrelazadas, preparadas de la misma manera, y calculando un promedio estadístico.

Medidas débiles

La teoría de la medición débil (la primera propuesta y desarrollada por Aharonov y su grupo en 1988), establece que es posible "suave" o "débilmente" medir un sistema cuántico, y obtener alguna información acerca de una propiedad (digamos, la posición), sin una alteración apreciable de una propiedad complementaria (moméntum), y por tanto, de la evolución futura del sistema. Aunque la cantidad de información obtenida por cada medida es muy pequeña, el promedio de múltiples mediciones nos da una estimación precisa de la medida de una propiedad sin distorsionar su valor final.

Cada medición débil puede decirnos algo acerca de las probabilidades de los diferentes estados (el valor de espín arriba o abajo, por ejemplo), aunque con un montón de errores, sin colapsar realmente a las partículas en estados definidos, como sucedería con una medida fuerte. "La medida débil cambia el estado medido e informa sobre el estado localizado resultante", aclara Elitzur. "Pero hace esta labor de manera muy holgada, y el cambio que ocasiona en el sistema es más débil que la información que ofrece."

Como resultado, explica Elitzur, "cada una medida débil, en sí misma, no nos dice casi nada. Las mediciones proveen resultados fiables sólo después de calcularlas todas. Entonces, los errores se cancelan y se puede extraer alguna información sobre el conjunto como un todo."

En el experimento mental de los investigadores, los resultados de estas mediciones débiles coinciden con los de las medidas más fuertes, en el cual el experimentador elige libremente la orientación del espín a medir, a pesar de que los estados de las partículas están todavía por determinar tras las mediciones débiles. Lo que esto significa, explica Elitzur, es que dentro de la TSVF "una partícula entre dos mediciones posee los dos estados indicados por ambos, el pasado y el futuro".

La naturaleza es inquieta

El problema es que, solamente añadiendo la información consiguiente desde las medidas fuertes se pueden revelar lo que las mediciones débiles estaban "en realidad" diciendo. La información ya estaba allí, pero encriptada y sólo se expone en retrospectiva. Así que, la causalidad se conserva, aunque no exactamente como normalmente la conocemos. ¿Por qué existe esta censura no está claro, salvo desde una perspectiva casi metafísica. "La naturaleza es conocida por ser muy exigente para que nunca parezca inconsistente", comentó Elitzur. "Así que no aprecia demasiado la causalidad abierta hacia atrás, la gente a matar a sus abuelos y así sucesivamente."

Elitzur dice que algunos especialistas en óptica cuántica han expresado su interés en realizar este experimento en el laboratorio, y él piensa que no debería ser más difícil que estudios anteriores de entrelazamiento.

Charles Bennett de IBM's T. J. Watson Research Center en Yorktown Heights, Nueva York, es un especialista en la teoría de información cuántica, y no está muy convencido. Él ve la TSVF solamente como una manera de visualizar resultados, y cree que los resultados pueden ser interpretados sin ninguna "causalidad retroactiva" aparente, por lo que los autores están erigiendo un hombre de paja (una falacia). "Para hacer que su hombre de paja se vea más fuerte, utilizan un lenguaje que oscurece la diferencia crucial entre la comunicación y la correlación", señala. Y añade que es como un experimento de criptografía cuántica, en la que el emisor envía al receptor la clave de descifrado antes de enviar (o incluso decidir sobre) el mensaje, y luego afirma que la clave es de alguna manera una "anticipación" del mensaje.

Sin embargo, Aharonov y sus colegas, sospechan que sus hallazgos podrían tener incluso consecuencias para el libre albedrío. "Nuestro grupo sigue estando algo divididos sobre estas cuestiones filosóficas", dice Elitzur. En opinión de Aharonov, la discusión "es algo talmúdica: todo lo que vamos a hacer ya lo conoce Dios, pero tú todavía tienes la elección."

Referencia: Artículo origen

Suena imposible, de hecho puede estar violando uno de los principios más preciados de la ciencia, la causalidad, pero los investigadores dicen que las reglas del mundo cuántico conspiran para preservar la causalidad "ocultando" la influencia de las futuras elecciones hasta que esas decisiones hayan sido efectivamente realizadas.

Ocupando el corazón de esta idea está el fenómeno cuántico de "no localidad", en el que dos o más partículas existen en estados interrelacionados o "entrelazados", algo que queda indeterminado hasta que se efectúa la medición de uno de ellos. Una vez que la medición se lleva a cabo, el estado de la otra partícula instantáneamente también queda fijado, sin importar lo lejos que pueda estar. Albert Einstein, lo denominó "acción a distancia" en 1935, cuando argumentaba que la teoría cuántica debe estar incompleta. Los experimentos modernos han confirmado que esta 'acción instantánea', es de hecho, una realidad, y ahora resulta clave para llevar las tecnologías cuánticas a la práctica, como la computación cuántica y la criptografía.

Aharonov y sus colaboradores, describen el experimento para un gran grupo de las partículas entrelazadas. Y afirman que, bajo ciertas condiciones, la elección del experimentador que mide los estados de las partículas, se puede demostrar que afectan a los estados que tenían las partículas en un tiempo anterior, cuando se hizo una holgada medición. En efecto, la anterior medición "débil" se anticipa a la elección hecha en la posterior medición "fuerte".

4D en lugar de 3D

Este trabajo se basa en una forma de pensar acerca del entrelazamiento, llamada "two-state vector formalism" [formalismo vectorial de dos estados] (TSVF), propuesto por Aharonov hace tres décadas. La TSVF considera las correlaciones entre las partículas en un espacio-tiempo 4D, en lugar de un espacio 3D. "En tres dimensiones, parece que existe alguna influencia milagrosa entre las dos partículas distantes", dice el colega de Aharonov, Avshalom Elitzur, del Instituto de Ciencia Weizmann en Rehovot, Israel. "Tomado el espacio-tiempo como un todo, resulta una interacción continua que se extiende entre los eventos pasados y futuros."

Aharonov y su equipo, han descubierto ahora una implicación notable de la TSVF que incide sobre la cuestión de en qué estado está una partícula entre dos mediciones, una versión cuántica del famoso acertijo de Einstein sobre cómo podemos estar seguros de que la Luna está ahí sin mirarla. ¿Cómo podemos averiguar algo acerca de las partículas sin medirlas? La TSVF muestra que es posible llegar a esa información intermedia, haciendo mediciones suficientemente "débiles" de un montón de partículas entrelazadas, preparadas de la misma manera, y calculando un promedio estadístico.

Medidas débiles

La teoría de la medición débil (la primera propuesta y desarrollada por Aharonov y su grupo en 1988), establece que es posible "suave" o "débilmente" medir un sistema cuántico, y obtener alguna información acerca de una propiedad (digamos, la posición), sin una alteración apreciable de una propiedad complementaria (moméntum), y por tanto, de la evolución futura del sistema. Aunque la cantidad de información obtenida por cada medida es muy pequeña, el promedio de múltiples mediciones nos da una estimación precisa de la medida de una propiedad sin distorsionar su valor final.

Cada medición débil puede decirnos algo acerca de las probabilidades de los diferentes estados (el valor de espín arriba o abajo, por ejemplo), aunque con un montón de errores, sin colapsar realmente a las partículas en estados definidos, como sucedería con una medida fuerte. "La medida débil cambia el estado medido e informa sobre el estado localizado resultante", aclara Elitzur. "Pero hace esta labor de manera muy holgada, y el cambio que ocasiona en el sistema es más débil que la información que ofrece."

Como resultado, explica Elitzur, "cada una medida débil, en sí misma, no nos dice casi nada. Las mediciones proveen resultados fiables sólo después de calcularlas todas. Entonces, los errores se cancelan y se puede extraer alguna información sobre el conjunto como un todo."

En el experimento mental de los investigadores, los resultados de estas mediciones débiles coinciden con los de las medidas más fuertes, en el cual el experimentador elige libremente la orientación del espín a medir, a pesar de que los estados de las partículas están todavía por determinar tras las mediciones débiles. Lo que esto significa, explica Elitzur, es que dentro de la TSVF "una partícula entre dos mediciones posee los dos estados indicados por ambos, el pasado y el futuro".

La naturaleza es inquieta

El problema es que, solamente añadiendo la información consiguiente desde las medidas fuertes se pueden revelar lo que las mediciones débiles estaban "en realidad" diciendo. La información ya estaba allí, pero encriptada y sólo se expone en retrospectiva. Así que, la causalidad se conserva, aunque no exactamente como normalmente la conocemos. ¿Por qué existe esta censura no está claro, salvo desde una perspectiva casi metafísica. "La naturaleza es conocida por ser muy exigente para que nunca parezca inconsistente", comentó Elitzur. "Así que no aprecia demasiado la causalidad abierta hacia atrás, la gente a matar a sus abuelos y así sucesivamente."

Elitzur dice que algunos especialistas en óptica cuántica han expresado su interés en realizar este experimento en el laboratorio, y él piensa que no debería ser más difícil que estudios anteriores de entrelazamiento.

Charles Bennett de IBM's T. J. Watson Research Center en Yorktown Heights, Nueva York, es un especialista en la teoría de información cuántica, y no está muy convencido. Él ve la TSVF solamente como una manera de visualizar resultados, y cree que los resultados pueden ser interpretados sin ninguna "causalidad retroactiva" aparente, por lo que los autores están erigiendo un hombre de paja (una falacia). "Para hacer que su hombre de paja se vea más fuerte, utilizan un lenguaje que oscurece la diferencia crucial entre la comunicación y la correlación", señala. Y añade que es como un experimento de criptografía cuántica, en la que el emisor envía al receptor la clave de descifrado antes de enviar (o incluso decidir sobre) el mensaje, y luego afirma que la clave es de alguna manera una "anticipación" del mensaje.

Sin embargo, Aharonov y sus colegas, sospechan que sus hallazgos podrían tener incluso consecuencias para el libre albedrío. "Nuestro grupo sigue estando algo divididos sobre estas cuestiones filosóficas", dice Elitzur. En opinión de Aharonov, la discusión "es algo talmúdica: todo lo que vamos a hacer ya lo conoce Dios, pero tú todavía tienes la elección."

Referencia: Artículo origen

La CERN construirá otro Colisionador de Hadrones más grande

Los científicos de la Organización Europea para la Investigación Nuclear (CERN) que hallaron ‘la partícula de Dios’ intentan construir un nuevo Gran Colisionador de Hadrones para sondear otro gran misterio del universo: la naturaleza de gravedad.

El grupo de investigadores que comprobó una alta probabilidad de la existencia del bosón de Higgs o 'partícula de Dios', está dispuesto a ampliar los horizontes de la ciencia con un Gran Colisionador de Hadrones (LHC) aún mayor.

Los científicos propusieron crear un nuevo LHC que sea tres veces mayor que el actual, que costó unos 4.600 millones de dólares y se encuentra cerca de Ginebra.

Se espera que la nueva herramienta científica conste de 80 kilómetros de circunferencia y bien sustituya a las instalaciones del actual LHC, enterrado a 150 bajo tierra en la frontera franco-suiza, o bien quede emplazado un lugar completamente nuevo.

El gran reto para este ‘colisionador 2’ será investigar las misteriosas características de la gravedad y su naturaleza, para entender de qué modo sus leyes se cumplen tanto al nivel de partículas subatómicas, como a nivel planetario, de estrellas y de galaxias.

En cualquier caso, es poco probable que el nuevo LHC sea construido antes del año 2025, aunque los investigadores no parecen dispuestos a esperar tanto como hizo Higgs, que aguardó 68 años hasta que su teoría fue casi comprobada.

La propuesta será presentada esta semana en la reunión de uno de los organismos de CERN.

El grupo de investigadores que comprobó una alta probabilidad de la existencia del bosón de Higgs o 'partícula de Dios', está dispuesto a ampliar los horizontes de la ciencia con un Gran Colisionador de Hadrones (LHC) aún mayor.

Los científicos propusieron crear un nuevo LHC que sea tres veces mayor que el actual, que costó unos 4.600 millones de dólares y se encuentra cerca de Ginebra.

| Imagen: cern.org |

Se espera que la nueva herramienta científica conste de 80 kilómetros de circunferencia y bien sustituya a las instalaciones del actual LHC, enterrado a 150 bajo tierra en la frontera franco-suiza, o bien quede emplazado un lugar completamente nuevo.

El gran reto para este ‘colisionador 2’ será investigar las misteriosas características de la gravedad y su naturaleza, para entender de qué modo sus leyes se cumplen tanto al nivel de partículas subatómicas, como a nivel planetario, de estrellas y de galaxias.

En cualquier caso, es poco probable que el nuevo LHC sea construido antes del año 2025, aunque los investigadores no parecen dispuestos a esperar tanto como hizo Higgs, que aguardó 68 años hasta que su teoría fue casi comprobada.

La propuesta será presentada esta semana en la reunión de uno de los organismos de CERN.

La Cosmología, dentro y fuera de la física

Los temas cosmológicos, en mi modesta opinión, tienen sentido físico específico cuando sus predicados se pueden observar, aunque sea por medios indirectos. Y por lo tanto medir, modelar, detectar y predecir.

Especular acerca del fin del universo basándose en el hipotético efecto de una supuesta materia oscura que aún nunca nadie vio -y que, para peor, aparenta ser imposible de ver- puede resultar interesante, pero no parece que sea una actividad que encaje del todo en la física.

Más bien es una actividad que simplemente consiste en teorizar sobre la viabilidad de determinados modelos matemáticos.

Esto puede servir legítimamente como conjetura de algo posible, lo que tiene en sí cierto mérito.

La simple caída de un cuerpo tirado desde un edificio, está gobernada por una ecuación cuadrática elemental con dos soluciones, una de las cuales no tiene sentido, pues involucra un tiempo "negativo", sin que haya nada misterioso en ello.

Las ecuaciones cosmológicas son extremadamente más complejas, pues están formuladas en términos de derivadas parciales tensoriales. Tales ecuaciones se parecen al sombrero de copa de un mago, ya que tienen muchas soluciones diferentes, que emergen como conejos, aparte de las descubiertas por Einstein y Hilbert. Éstas últimas están muy respaldadas experimentalmente en sus predicados, lo que constituye su principal argumento a favor, y por lo tanto constituyen un éxito de la cosmología física. Además de estas soluciones, existen muchas otras. Una de ellas, detectada por el eminente lógico alemán Kurt Gödel, introduce la posibilidad de viajar por el tiempo. Como juego, sin el menor respaldo experimental, la posibilidad es maravillosa. Pero los fundamentos de tales conclusiones deben aclararse bien para evitar encandilar falsamente a la gente sencilla como uno. La mitología hindú tiene, en su extenso catálogo de seres notables, a un dios fascinante llamado Narada, que vuela en una nave espacial a través del cosmos, con el permiso de Vishnú. Probablemente Gödel y Narada ya se hayan encontrado en el Cosmos varias veces para tomar cerveza alemana, aunque todavía no nos hemos dado cuenta de ello.

Referencia del autor:

Ricardo Miró (nacido en Buenos Aires, Argentina, en 1948) es Licenciado en Ciencias Matemáticas por la Universidad de Buenos Aires, y fue alumno del matemático catalán Luis Antonio Santaló y del matemático argentino Alberto Calderón. Trabaja en su país en el ámbito de la Comisión Nacional de Gestión Judicial, dependiente de la Corte Suprema de Justicia de la Nación. Ha estudiado en tal lugar varios problemas de congestión administrativa, y ha planteado modelos matemáticos para resolverlos, utilizando los recursos de la teoría de colas y de la teoría de juegos. Tiene publicados alrededor de 50 trabajos específicos sobre estos temas, algunos de los cuales han aparecido en los Anales de la Academia Nacional de Ciencias de Buenos Aires. También ha publicado varios libros de divulgación de las matemáticas, incluyendo como tema la teoría de la probabilidad. Disertó en la Academia Nacional de Ciencias de la República Checa, en Praga, en la Facultad de Ciencias Exactas de la Universidad de Buenos Aires, en la Universidad Nacional de Córdoba (Argentina) y en el Instituto Balseiro de Bariloche.

Podrían existir planetas en el corazón de la Vía Láctea

Pese a las condiciones hostiles que existen en el centro de la Vía Láctea y sus alrededores, podrían estar formándose nuevos planetas allí, de acuerdo con los estudios de un grupo de astrónomos. El hallazgo, publicado en un artículo de la revista Nature Communications, ha sorprendido a la comunidad científica, dado que el corazón de nuestra galaxia parecía reunir condiciones poco favorables para la formación de planetas. Es un lugar donde se arremolinan estrellas, se acumula una gran cantidad de energía que llena la región de ondas de impacto y mareas de radiación y donde existen fuerzas gravitatorias gigantescas capaces de deformarlo todo.

Pese a ello, un grupo de astrónomos del Centro de Astrofísica Harvard Smithsonian, afirma que allí pueden nacer nuevos planetas.

Llegaron a esta conclusión tras descubrir una nube de hidrógeno y helio precipitándose hacia el centro de la galaxia y a punto de ser devorada por el agujero negro central, tal y como se puede observar en la fotografía. Según los expertos, esa nube está compuesta por restos de lo que una vez fue un disco protoplanetario alrededor de una estrella que aún no ha sido descubierta.

Dicha nube fue hallada el año pasado y entonces se especuló con que se hubiese formado debido al choque de los chorros de gas de dos estrellas cercanas entre sí. Sin embargo, según los autores del estudio, Murray-Clay y Avi Loeb, las estrellas recién nacidas retienen a su alrededor y durante varios millones de años, un halo de gas y polvo (es decir, material sobrante de su formación) del que después, eventualmente, surgirán los planetas de su sistema. Pero si una estrella se precipita contra el agujero negro del centro de la galaxia, la radiación y las mareas gravitatorias pueden arrancarle el disco en cuestión de unos pocos años.

Aunque el disco protoplanetario (la nube de gas y polvo) se destruya, las estrellas que aún están en el anillo continúan sujetando con fuerza sus propios discos de acreción, por lo que muchas podrían estar formando planetas, pese a las condiciones extremas de sus alrededores.

“Si nuestra civilización habitara en uno de esos planetas, habríamos podido probar mucho mejor que aquí las teorías gravitatorias de Einstein", señaló Loeb, según la publicación.

Convierten un haz láser en una fila de fotones aislados

En teoría, las computadoras cuánticas serán capaces de realizar ciertos tipos de cálculos complejos mucho más deprisa de lo que pueden hacerlo los ordenadores convencionales, y por otra parte la comunicación cuántica parece que será invulnerable al espionaje. Sin embargo, pasar de la teoría a la práctica, y comenzar a fabricar componentes cuánticos para dispositivos específicos ha demostrado ser un camino plagado de retos a cada cual más difícil.

Ahora, un equipo de investigadores en el Instituto Tecnológico de Massachusetts (MIT) en Cambridge, y la Universidad de Harvard, ambas instituciones estadounidenses, ha conseguido alcanzar un objetivo fundamental para avanzar en ese camino: la capacidad de convertir, de manera controlada, un haz láser en una especie de fila de fotones separados. La exitosa demostración de esta capacidad la ha realizado el equipo de Thibault Peyronel y Vladan Vuletic, ambos del MIT.

![[Img #9588]](https://lh3.googleusercontent.com/blogger_img_proxy/AEn0k_vvwIIqBkJxSA4cd7avHXnca_pnTHhvtMgGmWS1vn7cTkhyeoYRWFReHxZNA9V7orBJRtRU2QHOCaJcxnekAJUUSwKr-SX3LvwNVN9v7-ZHlCLbUmLHQgh0pqImq5RxxtqNYyc=s0-d)

Este logro podría permitir el desarrollo de nuevos dispositivos cuánticos, como por ejemplo puertas cuánticas, en las que un fotón individual cambia la dirección del movimiento, o polarización, de otro fotón. Este objetivo ha sido muy difícil de alcanzar porque los fotones normalmente interactúan, a lo sumo, muy débilmente entre ellos.

Para potenciar esas interacciones se necesitan átomos que interactúen fuertemente con los fotones, así como con otros átomos que, a su vez, puedan afectar a otros fotones. Por ejemplo, un fotón individual podría atravesar fácilmente una nube de esos átomos, pero cambiaría el estado de los átomos de tal manera que un segundo fotón quedaría bloqueado al tratar de atravesar la nube. Ello significa que si dos fotones tratan de atravesarla a la vez, sólo uno tendrá éxito, mientras que el otro será absorbido.

Por tanto, en el nuevo sistema, independientemente de cuántos fotones se envíen a dicha nube de átomos, por el otro lado sólo emerge uno a la vez. La nube actúa como una especie de puerta con torniquete, transformando una aglomeración caótica de gente en una sucesión ordenada de individuos.

En el trabajo de investigación y desarrollo tienen participación Mikhail Lukin y Ofer Firstenberg, de la Universidad de Harvard en Cambridge, Massachusetts.

Ahora, un equipo de investigadores en el Instituto Tecnológico de Massachusetts (MIT) en Cambridge, y la Universidad de Harvard, ambas instituciones estadounidenses, ha conseguido alcanzar un objetivo fundamental para avanzar en ese camino: la capacidad de convertir, de manera controlada, un haz láser en una especie de fila de fotones separados. La exitosa demostración de esta capacidad la ha realizado el equipo de Thibault Peyronel y Vladan Vuletic, ambos del MIT.

Para potenciar esas interacciones se necesitan átomos que interactúen fuertemente con los fotones, así como con otros átomos que, a su vez, puedan afectar a otros fotones. Por ejemplo, un fotón individual podría atravesar fácilmente una nube de esos átomos, pero cambiaría el estado de los átomos de tal manera que un segundo fotón quedaría bloqueado al tratar de atravesar la nube. Ello significa que si dos fotones tratan de atravesarla a la vez, sólo uno tendrá éxito, mientras que el otro será absorbido.

Por tanto, en el nuevo sistema, independientemente de cuántos fotones se envíen a dicha nube de átomos, por el otro lado sólo emerge uno a la vez. La nube actúa como una especie de puerta con torniquete, transformando una aglomeración caótica de gente en una sucesión ordenada de individuos.

En el trabajo de investigación y desarrollo tienen participación Mikhail Lukin y Ofer Firstenberg, de la Universidad de Harvard en Cambridge, Massachusetts.

Buscando un Exoplaneta

Desde el descubrimiento del primer planeta extrasolar, en 1995, la comunidad científica se encuentra inmersa en la búsqueda de más mundos de este tipo. A día de hoy, los resultados son excelentes: más de 770 planetas catalogados hasta la fecha. Al principio fueron planetas tan grandes como Júpiter, pero las nuevas técnicas han logrado localizar otros más pequeños, del tamaño de la Tierra. Ahora queda lo más difícil: identificar cuáles de éstos son habitables.

Dos astrofísicos, Michel Mayor y Didier Queloz, recibieron el pasado mes de junio el premio Fronteras del Conocimiento en Ciencias Básicas, que otorga la fundación BBVA. El galardón fue concedido en reconocimiento a su labor investigadora en la búsqueda de nuevos mundos, los exoplanetas. Ambos científicos son pioneros en este campo, puesto que descubrieron el primer planeta externo a nuestro Sistema Solar. En 1995, Michel Mayor y el entonces doctorando Didier Queloz trabajaban juntos en la Universidad de Ginebra. Queloz había realizado un análisis en 51 Pegasi, una estrella situada a 47,9 años luz de distancia a la Tierra. Utilizando las mediciones de velocidad radial, se sorprendió al encontrar alteraciones en esta medición cuya única explicación era la de que existiera un compañero invisible de la estrella: un planeta. Se trataba de un gigante gaseoso, cientos de veces mayor que Júpiter, con un período orbital de 4,2 días. El descubrimiento de este primer planeta extrasolar fue anunciado el 6 de octubre de 1995 por Mayor y Queloz en la revista Nature.

La existencia de 51 Pegasi b, y que bautizaron informalmente como Belerofonte, se confirmó a través de múltiples observaciones y, aquel ejercicio de análisis que el entonces estudiante de doctorado Queloz estaba realizando para perfeccionar sus habilidades, marcó un hito en la historia de la astronomía y de la ciencia.

El primer intento: la estrella de Barnard

Pero el anuncio de Mayor y Queloz no fue el primero. Durante muchos años se consideró que la estrella de Barnard podía tener un planeta extrasolar. Varias décadas antes, en 1963, el astrónomo Peter van de Kamp había realizado medidas astrométricas precisas del movimiento de esta estrella, y en ellas se podía apreciar un movimiento aparente de la estrella perturbado por lo que podría ser un planeta de tipo joviano. Tendría 0,0015 de la masa solar o 1,6 veces la masa de Júpiter. Un análisis más completo, publicado en 1969, ofrecía una nueva explicación a su movimiento perturbado: dos planetas (con masas iguales a 1,1 y 0,8 la masa de Júpiter) que giraban con períodos iguales a 26 y 12 años respectivamente.

Para complicar las cosas, un nuevo análisis de los datos de Van de Kamp, efectuado en 1973 por Jensen y Ulrych, parecía mostrar la presencia de varios planetas con masas reducidas y períodos de traslación más cortos. Sin embargo, un estudio publicado ese mismo año por Gatewood y Eichhorn demostró la incapacidad de comprobar la existencia de estos planetas por otros equipos, usando instrumentos y técnicas diferentes.

En los años 80, otros equipos habían medido también durante varios años y con mayor precisión el movimiento aparente de la estrella descartando la hipótesis de los planetas. Todavía en 1982 un nuevo análisis de Van de Kamp de mediciones astronómicas realizadas en el intervalo 1938-1981 produjo un nuevo resultado, distinto a los anteriores: dos planetas con masas iguales a 0,7 y 0,5 masas jovianas con períodos de traslación de 12 y 20 años. Tres años más tarde, Fredrick e Ianna publicaron nuevos resultados, de mayor precisión y exactitud, con los que demostraban la no existencia de estas perturbaciones y, por tanto, la de los presuntos planetas.

Van de Kamp falleció en mayo de 1995, sin que pudiera conocer el descubrimiento de 51 Pegasi-b, un planeta confirmado alrededor de otra estrella, y que marcó un antes y un después en la investigación astronómica.

Una lista que no para de crecer

51 Pegasi-b supuso que la comunidad científica mundial se tomase en serio la búsqueda de otros planetas externos. Hasta entonces, la posibilidad de existencia de nuevos mundos no pasaba de ser una mera conjetura estadística, cuestión que la comunidad científica no se planteó abordar hasta el hallazgo de los astrónomos suizos. Y los resultados no se hicieron esperar. Poco después del descubrimiento de Mayor y Queloz, Geofrrey Marcy, científico de la Universidad de California, anunció el descubrimiento de dos nuevos planetas extrasolares.

Desde entonces, universidades, agencias gubernamentales e incluso astrónomos aficionados se han unido en el empeño de esta búsqueda de nuevos mundos. Su resultado ha sido la localización y catalogación de un número considerable de exoplanetas. En el año 2000 se habían identificado 200 y, diez años más tarde, la cifra llegó a 500. A día de hoy, el número de planetas registrado asciende a más de 700.

El éxito de esta trepidante búsqueda no solo se debe al empeño de los astrónomos de todo el mundo, sino al avance en los instrumentos empleados y a las nuevas técnicas. Se han desarrollado sistemas automáticos en tierra, ubicados en observatorios astronómicos convencionales, así como en órbita, como el conocido Hubble, el Spitzer o el exitoso Kepler.

En cuanto a los métodos empleados, cada vez son más complejos y precisos. Los primeros ‘cazadores de planetas’ midieron las pequeñas perturbaciones gravitatorias en las estrellas observadas. A partir de éstas, se puede determinar el tamaño de planeta encontrado y su posición relativa a la estrella, algo muy importante para determinar si el objeto estudiado es habitable. Sin embargo este método no es capaz de detectar planetas mucho mayores que la Tierra.

Los cazadores de planetas: SuperWASP y HARPS

También se emplean técnicas como medir la luminosidad de las estrellas, que disminuye cuando el planeta pasa por delante. Este método es el que emplea el satélite europeo Corot. Además, se han desarrollado sistemas automáticos de búsqueda, como el proyecto SuperWASP (Búsqueda Gran Angular de Planetas) que consiste en un sistema de búsqueda automatizada de planetas extrasolares. SuperWASP consta de dos observatorios robóticos, el SuperWASP-North que se encuentra en el Observatorio del Roque de los Muchachos, en la isla La Palma (Islas Canarias) y SuperWASP-South en el Observatorio Astronómico Sudafricano. Cada uno de ellos se compone de un conjunto de ocho lentes de 200 milímetros de distancia focal, respaldados por cámaras CCD de alta calidad de 2000x2000 pixeles de resolución. Su objetivo final es cubrir todo el firmamento, analizando estrellas de hasta magnitud 15. Desde septiembre de 2006 hasta la fecha, SuperWASP ha descubierto 39 planetas gigantes gaseosos similares a Júpiter.

Un sistema más preciso, o dicho de otro modo, que permite identificar mundos más pequeños, es el HARPS. Este espectrógrafo de alta precisión fue inaugurado en 2003 y está instalado en el observatorio ESO en La Silla, Chile. Recientemente se ha inaugurado otro sistema HARPS, para el hemisferio norte, en el IAC. Fue noticia por ser empleado en la investigación de las “SuperTierras” que se hizo público en abril de 2012. Se trata de planetas rocosos 2,5 veces que nuestro mundo y que orbitan alrededor del 40 % de las estrellas rojas, las más comunes en nuestra galaxia. Aparte, HARPS ya había descubierto más de 40 planetas, entre ellos el Gliese-581d, en 2007. Aunque Gliese 581 d orbita fuera de la zona de habitabilidad de su estrella, hay científicos que aseguran que podría soportar vida.

Kepler y su equipo

De todos los proyectos de caza de exoplanetas, el más exitoso es, sin duda, la misión Kepler. La NASA emprendió en 2009 este proyecto, bautizado en honor del famoso astrónomo, destinada a la búsqueda de planetas más pequeños que Júpiter. Kepler se une a los 15 proyectos que la administración norteamericana ha emprendido, sumándose al esfuerzo común de la comunidad científica en la búsqueda de otros mundos.

"La misión Kepler, por primera vez, permite a los humanos examinar nuestra galaxia por planetas del mismo tamaño que la Tierra o planetas aún más pequeños," según palabras del investigador William Borucki de la NASA. En diciembre de 2011, la agencia anunció que el número de candidatos detectados hasta la fecha ascendía a 2326. De ellos, 207 tendrían un tamaño similar a la Tierra, aunque sólo uno (Kepler-22b) estaba confirmado.

Y no solo Kepler está en esta labor. El pasado 19 de julio la agencia creía haber detectado un planeta, el UCF-1.01, de un tamaño equivalente a dos tercios de la Tierra. El descubrimiento se producía gracias al telescopio Spitzer, concebido inicialmente para estudiar objetos fríos que van desde el Sistema Solar exterior hasta los confines del universo. Además, otro nuevo aparato promete futuros descubrimientos. El JWST, proyecto con el que nuestro país también colabora, será el telescopio espacial con mayor diámetro que operará en el infrarrojo medio y cercano y podrá explorar los confines del universo, detectando y caracterizando las primeras galaxias. Permitirá también investigar los estadios iniciales de la formación de estrellas así como la formación de discos planetarios alrededor de las mismas y analizar y caracterizar la complejidad química de las atmósferas de exoplanetas. Se dará así un paso más en la investigación exoplanetaria, con la identificación de planetas habitables.

El siguiente paso

Con multitud de planetas nuevos sobre la mesa lo que se busca ahora es cuales de éstos (y de los que se encuentren en un futuro) pueden ser habitables. Lo serían si su masa es suficiente como para que su atracción gravitatoria pueda retener una atmósfera y su temperatura sea la adecuada para permitir tener agua líquida. La forma de averiguar esto último es identificando la posición relativa del planeta respecto a su estrella, dentro de una región llamada habitable. En nuestro sistema solar, la franja habitable está evidentemente ocupada por La Tierra, y abarca desde Venus hasta Marte. Más cerca de Venus, el agua estaría tan caliente que se evaporaría de inmediato, mientras que más allá de Marte, el agua estaría siempre en forma de hielo.

En esta búsqueda solamente se han identificado cinco planetas potencialmente habitables. Uno es Gliese 581g, descubierto en 2010 y puesto en duda casi una semana después. Gracias a nuevos datos del HARPS, se ha vuelto a considerar como posible candidato. Así, los astrónomos han definido un parámetro, el índice de ISE que mide el parecido del planeta estudiado con la Tierra, en una escala de 0 a 1. Gliese 581g tendría un índice de 0,92, luego su ‘candidatura’ está justificada.

Y por si alguien se puede plantear como posible la idea de una colonización de esos planetas, solo un dato. Si quisiéramos viajar por ejemplo a Gliese 581g, que se encuentra a 20,3 años luz de la Tierra, con los medios de propulsión actuales se tardaría alrededor de 369.000 años. Lo más lejos que ha llegado un objeto fabricado por la humanidad es a 0,002 años luz de la Tierra después de 33 años de viaje, la Voyager 1.

El futuro de la investigación exoplanetaria